13 Abschluss

13.1 Lernsteuerung

13.1.1 Lernziele

Nach Absolvieren des jeweiligen Kapitels sollen folgende Lernziele erreicht sein.

Sie können …

- erläutern, wie Sie eine typische, sozialwissenschaftliche Forschungsfrage (quantitativ) untersuchen

- typische “Lieblingsfehler” benennen und Wege aufzeigen, um die Fehler zu umgehen

- zwischen den Grundkonzepten der Frequentististischen Statistik und der Bayes-Statistik übersetzen

- die Grundideen der Bayes-Statistik in eine Gesamtzusammenhang einordnen

13.1.2 Benötigte R-Pakete

In diesem Kapitel benötigen Sie folgende R-Pakete.

13.1.3 Begleitvideos

13.2 Probeklausur

13.2.1 2024

(Diese Liste ist im Aufbau. Bitte konsultieren Sie für weitere Aufgaben selbständig alle relevanten Aufgaben, die in den Kapiteln vorgestellt wurden.)

- ttest-als-regr

- Additionssatz1

- Nerd-gelockert q

- Urne1

- corona-blutgruppe

- voll-normal

- alphafehler-inflation3

- verteilungen-quiz-05

- verteilungen-quiz-03

- verteilungen-quiz-04

- Kekse03

- globus-bin2

- globus2

- iq01a

- gem-wskt4

- Rethink2m3

- mtcars-post2a

- groesse03

- bath42

- klausur-raten

- bed-post-wskt1

- mtcars-post3a

- exp-tab

- norms-sd

- mtcars-post_paper

- bfi10

- rope-luecke

- wskt-schluckspecht2a

- penguins-stan-06

13.2.2 2023

Dieser Tag auf dem Datenwerk stellt Fragen einer Probeprüfung (Version 2023) zusammen.

13.2.3 2022

Dieser Tag auf dem Datenwerk stellt Fragen einer Probeprüfung (Version 2022) zusammen.

13.3 Lieblinglingsfehler

Lieblingsfehler im Überblick 🤷:

- Quantile und Verteilungsfunktion verwechseln

- Prädiktoren nicht zentrieren, wenn es einen Interaktionsterm gibt

- Interaktion falsch interpretieren

- Regressionskoeffizienten kausal interpretieren, wenn es keine kausale Fundierung gibt

13.3.1 Post-Präd-Verteilung (PPV) und Post-Verteilung verwechseln 🤷

🏎 🏎 Vertiefung: Dieser Abschnitt ist nicht prüfungsrelevant. 🏎️ 🏎

Berechnen wir unser Standard-mtcars-Modell: mpg ~ hp.

Code

m1 <- stan_glm(mpg ~ hp, data = mtcars, refresh = 0)Die Post-Verteilung zeigt Stichproben zu den Parameterwerten, s. Tabelle 13.1.

Diese Tabelle kann man hernehmen, um Fragen zu Post-Verteilung zu beantworten. Häufig ist es aber bequemer, z.B. mit parameters(m1) Post-Intervalle und Punktschätzer auszulesen.

Die Posterior-Prädiktiv-Verteilung (PPV) zeigt die Vorhersagen, also keine Parameterwerte, sondern Beobachtungen.

name <chr> | value <dbl> | |||

|---|---|---|---|---|

| Mazda RX4 | 15.40342 | |||

| Mazda RX4 Wag | 20.81143 | |||

| Datsun 710 | 22.39144 | |||

| Hornet 4 Drive | 23.01285 | |||

| Hornet Sportabout | 14.56789 |

13.3.2 Quantile und Verteilungsfuntion verwechseln 🤷

13.3.2.1 Quantil für

Ein  ::: :::

::: :::

Das 50%-Quantil (.5-Quantil) beträgt

13.3.2.2 Verteilungsfunktion

13.3.3 Interaktion falsch interpretieren 🤷

Berechnen wir ein einfaches Interaktionsmodell: mpg ~ hp*vs.

Zur Erinnerung: mpg ~ hp*vs ist synonym zu (aber kürzer als) mpg ~ hp + vs + hp:vs.

Code

m2 <- stan_glm(mpg ~ hp*vs, data = mtcars) # mit InteraktionseffektModellkoeffizienten, s. Tabelle 13.2.

Code

parameters(m2)| Parameter | Median | 95% CI | pd | Rhat | ESS | Prior |

|---|---|---|---|---|---|---|

| (Intercept) | 24.67 | (19.01, 30.20) | 100% | 1.001 | 2166.00 | Normal (20.09 +- 15.07) |

| hp | -0.04 | (-0.07, -0.01) | 99.70% | 1.001 | 2146.00 | Normal (0.00 +- 0.22) |

| vs | 13.90 | (4.74, 23.40) | 99.75% | 1.003 | 1506.00 | Normal (0.00 +- 29.89) |

| hp:vs | -0.11 | (-0.20, -0.03) | 99.28% | 1.003 | 1608.00 | Normal (0.00 +- 0.31) |

Tabelle 13.2 zeigt die Visualisierung der Parameter von m2.

Code

plot(parameters(m2))Falsch 😈 Der Unterschied im Verbrauch zwischen den beiden Gruppen vs=0 und vs=1 beträgt ca. -0.11.

Richtig 👼 Der Unterschied im Verbrauch zwischen den beiden Gruppen vs=0 und vs=1 beträgt ca. -0.11 – wenn hp=0.

Da hp=0 kein realistischer Wert ist, ist das Modell schwer zu interpretieren. Zentrierte Prädiktoren wären hier eine sinnvolle Lösung.

13.4 Kochrezepte 🍲

13.4.1 Kochrezept: Forschungsfrage untersuchen

Theoretische Phase 1. Staunen über ein Phänomen,

Empirische Phase

- Versuch planen

- Daten erheben

Analytische Phase

- Daten aufbereiten

- Modell berechnen anhand eines oder mehrerer DAGs

- Modell prüfen/kritisieren

- Forschungsfrage beantworten

Yeah! Fertig.

13.4.2 Parameter schätzen vs. Hypothesen prüfen

Quantitative Studien haben oft einen von zwei (formalen) Zielen: Hypothesen testen oder Parameter schätzen. Beispiel Hypothesenprüfung: “Frauen parken im Durchschnitt schneller ein als Männer”. Beispiel Parameterschätzung: “Wie groß ist der mittlere Unterschied in der Ausparkzeit zwischen Frauen und Männern?”

Je ausgereifter ein Forschungsfeld, desto kühnere Hypothesen lassen sich formulieren: - stark ausgereift: - Die nächste totale Sonnenfinsternis in Deutschland wird am 27.7.2082 um 14.47h stattfinden, Quelle - gering ausgereift: - Die nächste Sonnenfinsternis wird in den nächsten 100 Jahren stattfinden. - Lernen bringt mehr als Nicht-Lernen für den Klausurerfolg. Kühne Hypothesen sind wünschenswert 🦹

13.4.3 Formalisierung von Forschungsfragen

Der Mittelwert in Gruppe A ist höher als in Gruppe B (der Unterschied,

13.5 Kerngedanken Bayes

13.5.1 Zentraler Kennwert der Bayes-Statistik: Post-Verteilung

Berechnen wir wieder ein einfaches1 Modell: mpg ~ hp.

Code

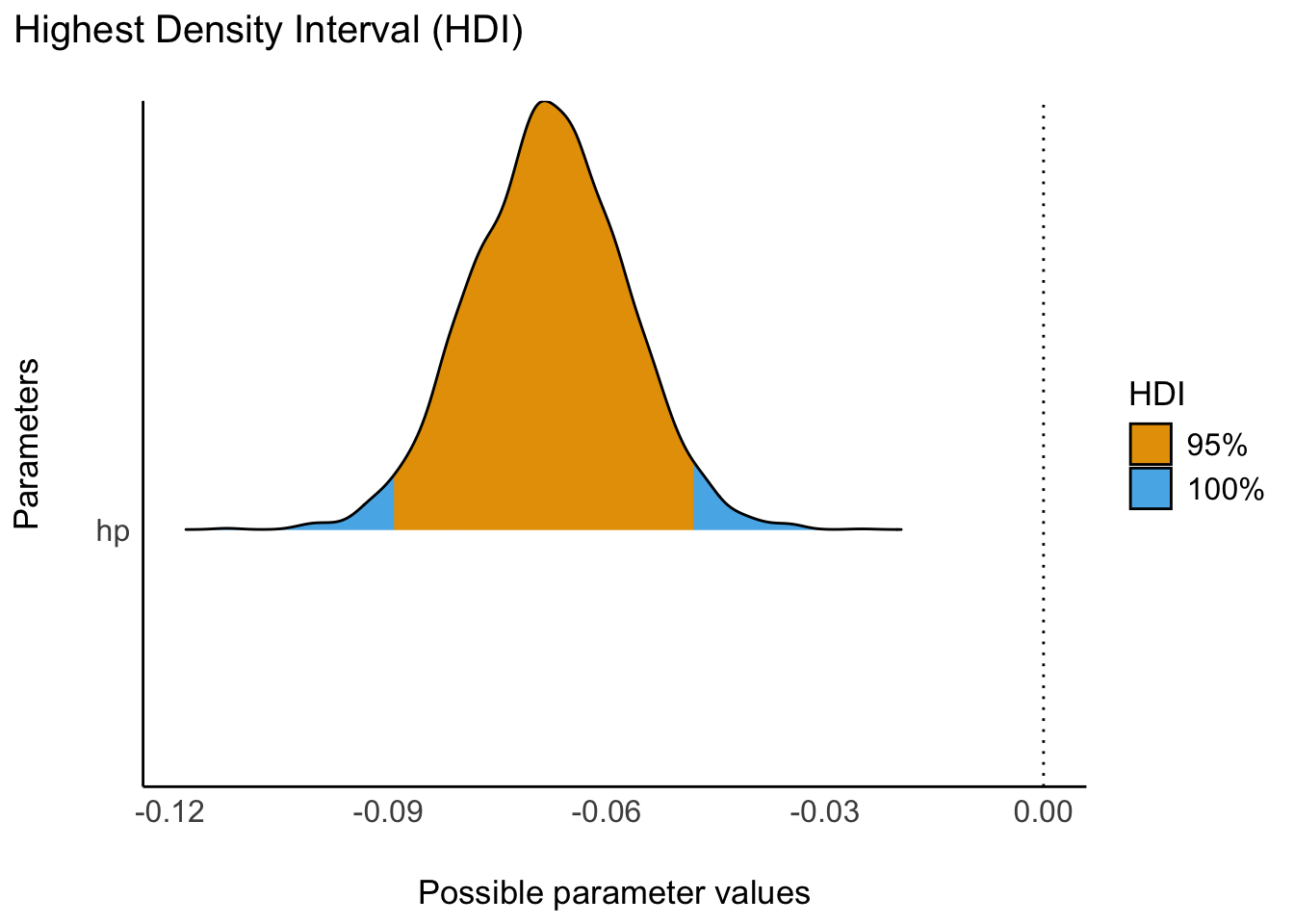

m3 <- stan_glm(mpg ~ hp, data = mtcars)Und schauen wir uns die Post-Verteilung an, mit eingezeichnetem HDI, s. Abbildung 13.3.

Ein Zusammenfassen der Posterior-Verteilung (z.B. zu einem 95%-PI) ist möglich und oft sinnvoll. Verschiedene Arten des Zusammenfassens der Post-Verteilung sind möglich, z.B. zu Mittelwert oder SD oder einem einem HD-Intervall. Allerdings übermittelt nur die gesamte Post-Verteilung alle Informationen. Daher empfiehlt es sich (oft), die Post-Verteilung zu visualisieren.

13.5.2 Posteriori als Produkt von Priori und Likelihood

13.6 Beispiele für Prüfungsaufgaben

13.6.1 Geben Sie den korrekten Begriff an!

🌬🚙🙋️👨⬅️Hans 👧⬅️Anna 👩⬅️Lise

Puh, wie erstelle ich für alle Studis ein anderes Rätsel2?

13.6.2 DAG mit doppelter Konfundierung

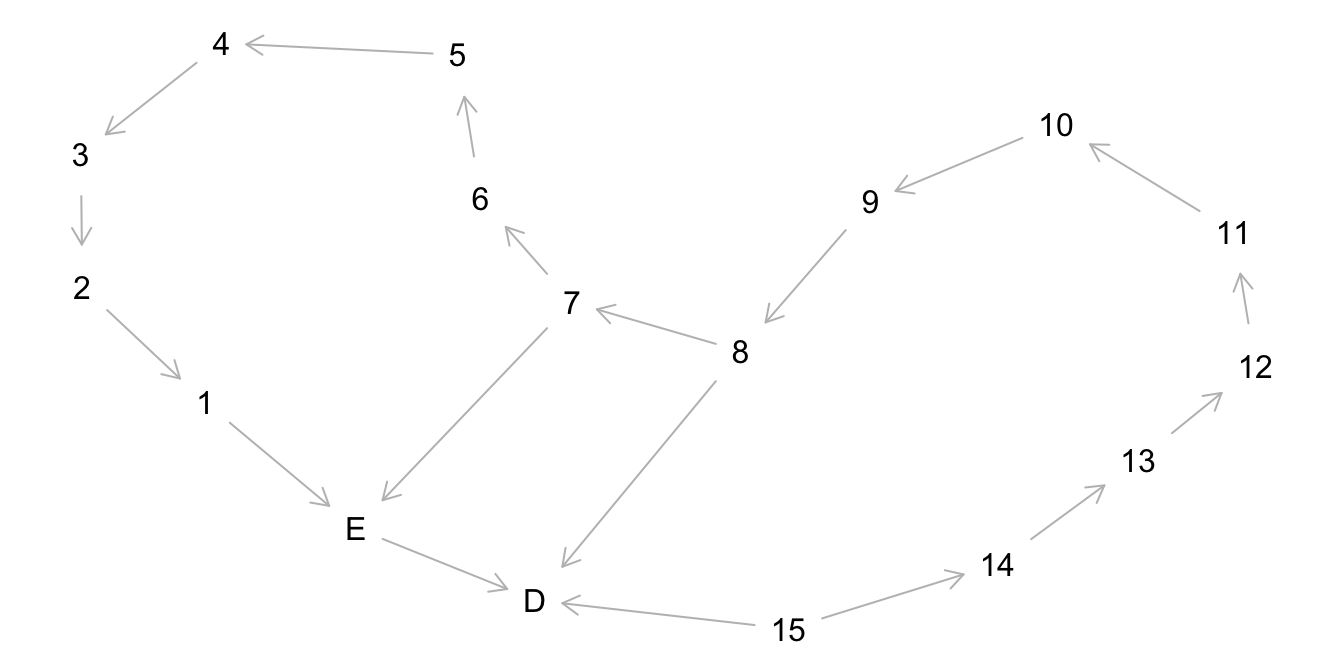

Puh, jetzt kommt ein wilder DAG, s. Abbildung 13.4.

Definition 13.1 (Minimale Adjustierungsmenge) die Minimale Adjustierungsmenge für x und y gibt eine kleinstmögliche Menge an an Knoten eines DAGs an, die zu adjustieren sind, um den kausalen Effekt von x auf y zu bestimmen (zu “identifizieren”).

❓Geben Sie die minimale Adjustierungsmenge (minimal adjustment set) an, um den totalen (gesamten) Effekt von E auf D zu bestimmen!

❗ Entweder ist die Menge {A,Z} zu adjustieren oder die Menge {B,Z}.

Ja, dem DAG ist zu helfen.

13.6.3 DAG mit vielen Variablen

Je nach dem wie komplex Ihre Theorie ist, ist Ihr DAG auch komplex, s. Abbildung 13.5.

Minimale Adjustierungsmenge, um den Effekt von E auf D zu identifizieren: {7}, {8}.

Trotz der vielen Variablen, ist der kausale Effekt von E auf D recht gut zu identifizieren.

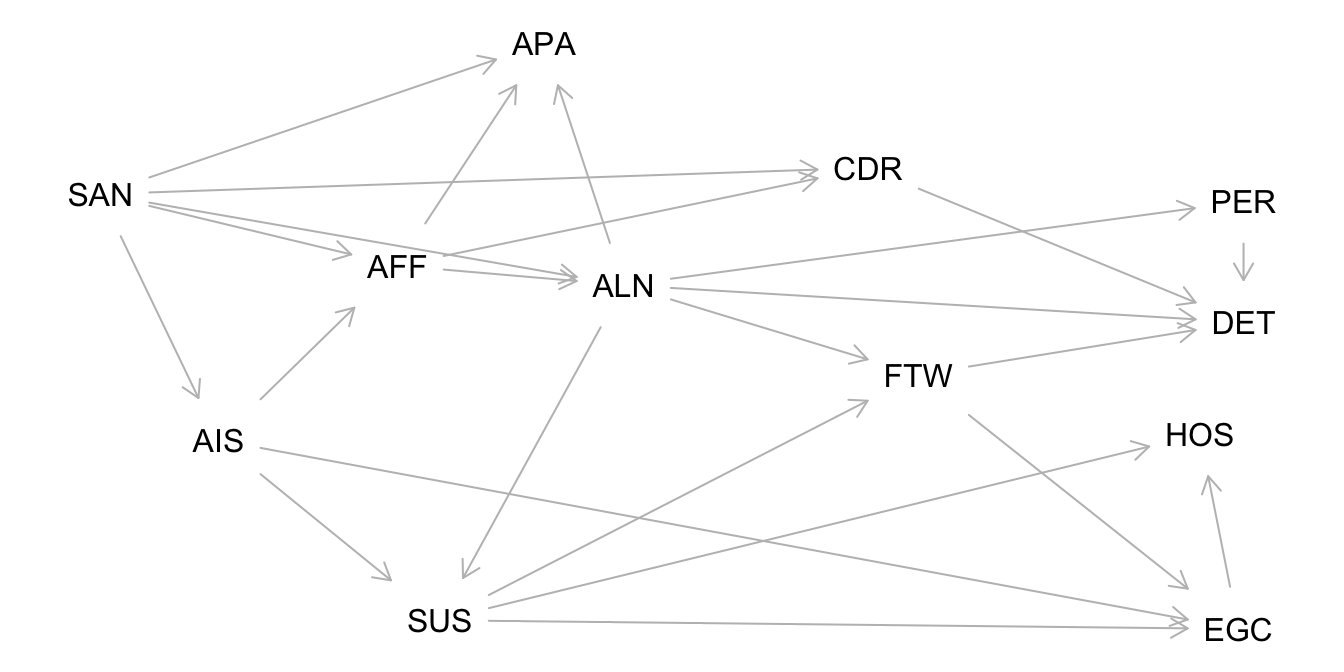

13.6.4 Ein Kausalmodell der Schizophrenie, van Kampen (2014)

The SSQ model of schizophrenic prodromal unfolding revised:

An analysis of its causal chains based on the language of directed graphs

D. van Kampen

Lesen Sie hier den Abstract.

Folgende Symptome der Schizophrenie wurden gemessen:

Social Anxiety (SAN), Active Isolation (AIS), Affective Flattening (AFF), Suspiciousness (SUS), Egocentrism (EGC), Living in a Fantasy World (FTW), Alienation (ALN), Apathy (APA), Hostility (HOS), Cognitive Derailment (CDR), Perceptual Aberrations (PER), and Delusional Thinking (DET)

van Kampen (2014)

UV: SUS, AV: EGC

Berechnen Sie die minimale Adjustierungsmenge, um den kausalen Effekt der UV auf die AV zu identifizieren!

Abbildung 13.6 zeigt den DAG von van Kampen (2014) zu den Symptomen der Schizophrenie.

Minimales Adjustment-Set für den totalen Kausaleffekt: {AIS, ALN}

13.6.5 Modelle berechnen

Stellen Sie sich auf Aufgaben ein, in denen Sie Modellparameter berechnen sollen. Orientieren Sie sich an den Aufgaben und Inhalten des Unterrichts.

Prüfungsfragen zu Modellen könnten z.B. sein:

- Geben Sie den Punktschätzer (Median) für den Prädiktor X im Modell Y an!

- Geben Sie ein 89%-HDI für den Parameter X im Modell Y an!

- Geben Sie R-Quadrat an.

- Formulieren Sie ein Interaktionsmodell!

- Welches Modell ist korrekt, um den kausalen Effekt zu modellieren?

- Formulieren Sie ein Modell mit folgenden Prioris …

- Liegt der Effekt X noch im ROPE ?

- Unterscheidet sich die Breite des CI von der Breite des HDI für den Prädiktor X im Modell Y?

- Was verändert sich an den Parametern, wenn Sie die Prädiktoren zentrieren/z-standardisieren?

- …

13.7 Aufgabensammlungen

Folgende Tags auf dem Datenwerk beinhalten relevante Aufgaben3:

Besondere “Prüfungsnähe” könnten diese Sammlungen haben:

13.8 Viel Erfolg bei der Prüfung!

🥳🏆🍀🍀🍀

13.9 —